FedFMSL:使用稀疏激活LoRA的基础模型的联邦学习

FedFMSL:使用稀疏激活LoRA的基础模型的联邦学习

FedFMSL: Federated Learning of Foundation Models With Sparsely Activated LoRA

摘要:抽象基础模型(Abstract-Foundation Models,简称FM)在自然语言处理等中取得了巨大的成功。FM具有大量的模型参数,因此,在训练过程中需要大量的数据来帮助优化模型。联邦学习通过从分散的数据中进行协作学习,同时仍然保护客户的数据隐私,从而彻底改变了机器学习。模型可以通过联邦学习来增强,其庞大的模型参数给现代网络带来了严峻的通信挑战,特别是对边缘设备带来了计算挑战。此外,不同客户端的数据分布可能不同,从而导致统计挑战。我们提出了一个新的两个-阶段联邦学习算法称为FedFMSL。在第一阶段训练全局专家,在第二阶段训练局部专家,以提供更好的个性化。我们利用这两个专家构建了一个混合基础模型(MoFM),并设计了一个在第二阶段每个通信轮加入聚合的门适配器的门神经网络。为了进一步适应计算资源有限的边缘计算场景,我们设计了一种新的稀疏激活LoRA(SAL)算法,该算法冻结了预先训练的基础模型参数,并将低秩自适应矩阵插入到Transformer会阻塞,并在训练过程中逐步激活它们。通过大量的实验验证了FedFMSL算法的有效性,结果表明,FedFMSL算法在缺省设置下,在基础模型参数调整不到0.3%的情况下,其性能比其他SOTA算法提高了59.19%。

结论:本文提出了一种新的FedFMSL算法,该算法包含两个训练阶段,以解决基于基础模型的联邦学习中带宽密集型、计算密集型和客户端数据异构性的挑战。在第一阶段,我们冻结预训练的FM权重,并在每个Transformer块中插入低秩分解矩阵。在每一轮通信中,只有低秩分解矩阵的参数参与权值聚合,与全部参数传输相比,节省了99.9%以上的通信带宽。我们以第一阶段培训的FM为全球专家,再构建一个本地专家,为个人客户提供个性化服务。我们是首次将全局专家和局部专家作为联邦学习中的基础模型混合体(MoFM)。我们专门设计了一个门适配器,并将其插入到门模型中,以帮助分配两个专家的决策权重。门适配器的聚合可以获得有竞争力的性能,同时节省97.69%的通信资源消耗。此外,为了在计算稀缺的场景中实现高效的训练,我们提出了一种稀疏激活LoRA(SAL)算法,根据能力队列中过去的准确性逐步激活低秩自适应矩阵。我们通过在各种设置下的大量实验来测试FedFMSL的性能,结果表明,FedFMSL通过调整不到0.3%的基础模型参数来优于其他SOTA基线。

解决的问题

FM脱颖而出主要是由于大量的训练数据以及大量的参数。这种大量增加的参数空间和收集的数据中的复杂模式和关系使FM能够提高性能各种机器学习任务。然而,现有的FM是笨重的,带宽密集型和计算密集型的。这提出了一些挑战领域的FL与FM,这使得它很难在现实世界中的应用。为了弥补这一差距,本文提出了一种基于稀疏激活参数的混合基础模型的FL算法FedFMSL,该算法包括两个训练阶段,第一阶段协同训练全局基础模型,第二阶段训练局部基础模型,以提供更好的个性化。

本文的主要贡献可概括为:

1、提出了一种通信和计算友好的两阶段个性化FL算法FedFMSL,该算法通过协同学习获取全局特征信息,通过个性化学习获取局部特征信息,并对FedFMSL算法的收敛性进行了理论证明,

2、提出了一种稀疏激活LoRA(SAL)算法算法通过自定义的控制器以渐进的方式稀疏地激活注入到基础模型中的可训练低秩分解矩阵,以适应边缘计算场景中稀缺的计算和通信资源。

3、提出了一种基础模型混合(MoFM)算法,据我们所知,第一个工作,构建了一个混合的视觉语言基础模型的个性化联邦学习,以解决数据异构的联邦学习,我们进一步证明了FedFMSL的有效性,通过广泛的实验。

论文方法

两阶段训练微调

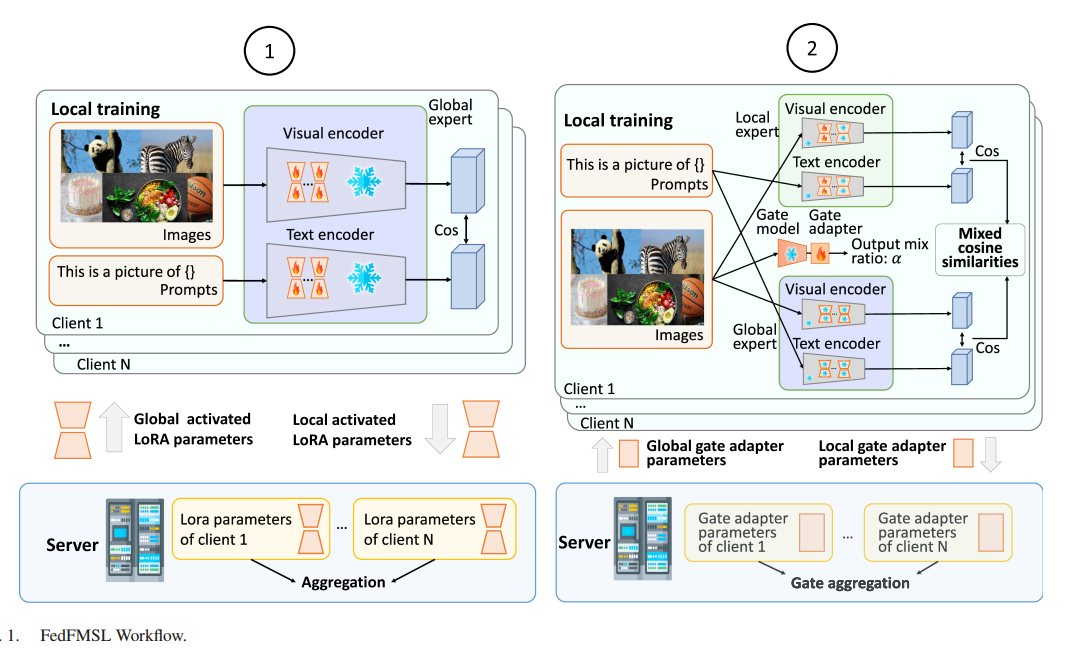

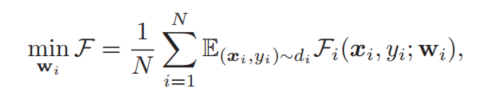

论文方法FedFMSL包括两个训练阶段,如图所示。在第一阶段,低秩自适应矩阵被插入到基础模型的每个Transformer块中[28]。在这个阶段中,所有插入的低秩自适应矩阵被激活以更好地从所有客户端提取一般信息,并且每个客户端协作地训练全局模型,这将是第二阶段的全球专家。第一阶段的学习目标为:

其中Fi表示客户端i ∈ [N]的损失函数; wi表示客户端i的模型的插入低秩自适应矩阵的参数; xi表示其私有数据; yi表示对应的标签,di表示客户i的数据分布。

在第二阶段,每个客户利用第一阶段中训练的全局专家,训练其个性化模型。该模型由全局专家,本地专家和门模型一起构成基础模型的混合。在此阶段,本地专家仅在客户的本地数据集上进行训练,并采用一种新的稀疏激活LoRA算法,不进行全局聚合,设计并在网关模型中插入一个网关适配器,聚合每轮通信中网关适配器的所有参数,以收集全局数据分布信息,从而更好地为两个专家分配权重。通过

其中ui表示客户端i的门适配器的参数; ei表示客户端i的本地专家的参数。

在本文中,我们使用典型的视觉语言基础模型CLIP来完成图像分类任务。在这些模型中,视觉编码器和文本编码器将输入图像和文本映射到高维特征向量。模型训练的目标是最小化相关对之间的余弦相似度,最大化不相关对之间的余弦相似度,在特征空间中对齐它们的表示。在评估期间,该模型为每个类别预先计算一组文本特征向量,然后计算输入图像特征向量与这些预先计算的文本特征向量之间的余弦相似度,相似度最高的类别即为分类结果。

我们提出了两种新的算法来解决FL与FM提出的挑战。

稀疏激活LoRA

论文根据lora的w=w0+AB的思想,在训练过程中,冻结W0,只优化WA和WB,这样可以节省计算和存储成本。

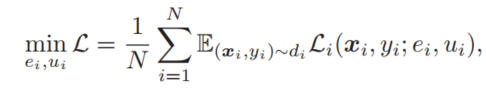

在这个基础上,我们在训练过程中稀疏地激活低秩分解矩阵,而不是全部激活它们。在训练阶段开始时,视觉编码器和文本编码器的每一层都插入了冻结的低秩分解矩阵。在第一个训练阶段,所有层的低秩分解矩阵被激活,以更好地提取一般信息,形成一个全局专家,而在第二个阶段,我们解冻低秩分解矩阵从高层到低层的训练过程中。

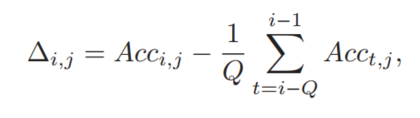

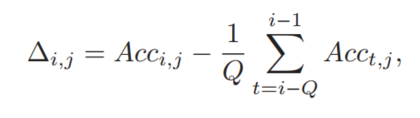

更具体地说,我们引入了一个最大队列长度为Q的能力队列。客户端的图像分类精度在每一轮通信后都会转发到能力队列。一旦能力队列满了,之前添加的精度就会弹出。我们设置了一个精度阈值δ来帮助判断训练是否进入瓶颈。客户端j在通信轮i中的增量因子Δ为

其中Acci,j表示客户端j的模型在第i轮通信中的图像分类精度,如果Δi,j < δ,则认为训练进入瓶颈,则激活下一层的低秩分解矩阵。

SAL算法的设计灵感来自于FM的性能通常受到模型大小、数据集大小和数据集质量的影响,对数据集进行分类需要优化更多的模型参数以更好地提取数据的语义含义,但是在使用FM训练FL时没有银配置。因此,我们引入能力队列来智能地决定激活的LoRA参数的数量,并使计算资源有限的设备上的训练成为可能。

混合基础模型

训练一个全局模型并将其应用于所有的客户端,不能满足不同客户端的数据分布不同的需求,训练个性化模型的同时利用全局模型是为不同客户端提供更好性能的关键。

为了解决这一挑战,我们设计了一种新的混合基础模型(MoFM)算法,利用一个FM作为全局专家,另一个FM作为本地专家,从而创建一个混合的基础模型,同时学习个性化的特征信息,以及每个客户端的全局特征信息。

如图1所示,在训练的第一阶段,每个客户端协同训练一个具有权重的全局FM。在视觉编码器和文本编码器的每一层中插入低秩分解矩阵。这个全局FM充当全局FM专家。在第二阶段,为每个客户端i创建本地专家以与全局专家合作。

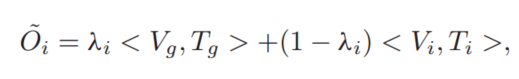

更具体地说,局部专家具有与全局专家相同的神经网络结构,并以全局专家的权重初始化,每个客户端i的门函数Gi是一个神经网络,用于控制全局专家和局部专家对给定不同图像的最终图像分类决策的相对贡献,我们用全局专家表示提取的图像特征和文本特征本地专家i提取的图像特征和文本特征为Vi和Ti。从客户端i的数据集中提取的图像特征和文本特征的最终余弦相似度可以表示为

其中λi ∈(0,1)是代表客户端i的全局专家和局部专家的混合比率的权重因子。较大的λi表示使用更多的全局知识,而较小的λi表示使用更多的个人知识。

在FedFMSL的第二个训练阶段,全局专家的权重被冻结,而局部专家和门模型仅使用客户端i的局部数据进行优化。适配器[33]是FM中流行的参数有效调谐方法。它通过在FM中插入很少的层并通过仅调谐插入的很少的参数来优化FM。我们设计了一种新的门适配器,以适应本地数据集,同时保持低的计算和通信成本。在每一轮通信中,客户端激活的门适配器参数被聚合以学习全局特征信息,从而保持低计算和通信成本。门适配器的聚合可以帮助门神经网络通过确定给定的数据是更服从用户的个性化数据分布还是全局数据分布来更好地为不同的专家分配权重。

我们将聚合后的门适配器的参数表示为u-global。具体来说,我们用多层感知器(MLP)、批规范层、MLP、批规范层和最后的Softmax函数来构建门适配器,以确保输出在(0,1)之间。门适配器聚合过程表示为:

证明

论文证明了 在这一节中,我们对FedFMSL算法的收敛性进行了深入的分析。我们首先证明了FedFMSL算法第一阶段的收敛性,然后证明了第二阶段的收敛性。对于第一阶段,我们引入了以下假设,这些假设是[34],[35]中常用的假设。

证明了两个阶段的收敛率都为O(1/√ T)

第一个证明利用L光滑与梯度期望有界的性质证明,比较简单。

第二个证明变量涉及两个e,u,原理类似但非常复杂,感觉有点难,没细看。

实验

论文数据集用了三个,Food101 ,EuroSAT ,UCF101 。

基线与Vanilla Fine-Tuning、PromptFL、LayerFreeze Fine-Tuning

论文分析了不同数据分布、不同数量的客户端、不同大小的encoder、不同学习率、不同队列阈值、不同lora秩值、不同dropout、不同权重衰减的影响、不同的基础模型FM

并给出了不同数据集中利用SAL算法激活lora层的数量

不同的资源消耗:训练参数的比例和总数、不同网络带宽下的通信时间

F1评分比较:为了更全面地评估不同算法的性能,我们还比较了不同算法在不同数据集下的F1得分。

消融研究:

基础模型混合架构的影响:我们比较了使用视觉编码器ViT-B/16的MoFM架构的模型和不使用MoFM架构的模型的图像分类准确度,该模型仅依赖SAL算法,同时结合了参数更密集的ViT-L/14视觉编码器,具有MoFM架构但具有较小视觉编码器的模型的参数比另一模型少27.33%。

虽然参数少得多,但采用MoFM架构并经过完整两个阶段训练的模型在所有数据集上都实现了更高的准确率。这个令人惊讶的结果证明了MoFM架构的优越性,因为它可以根据待分类图像的特征智能地为不同的专家分配不同的权重,这使得对不在客户本地数据集分布的数据具有更好的泛化能力,并且对遵循本地客户本地数据集分布的数据具有更好的个性化能力。

门参数聚合的影响:我们比较了FedFMSL和在第二个训练阶段激活所有门参数的FedFMSL的图像分类精度。我们可以从表III和表IV可以看出,仅通过微调门适配器的最后一层,我们可以在Food 101、UCF 101和EuroSAT数据集中实现93.79%、86.42%和99.07%的准确度,这仅比调整门模型的全部参数平均低0.05%,但节省了97.69%的通信资源消耗。

修改LoRA和适配器的影响:我们比较了FedFMSL的图像分类精度,LoRA+FL和Adapter+FL,其中LoRA+FL表示每个通信轮微调和聚合LoRA参数,Adapter+FL [23]表示每个通信轮微调和聚合Adapter参数。从结果中,我们可以观察到FedFMSL算法在三个数据集下的所有算法中达到最高的准确度。

个人体会

感觉论文的思路和自注意力机制有点像(也不知道对不对),先训练,关注到所有客户端的信息,然后用公共的知识与自身的知识训练微调。在后一阶段的过程中找到最适合自己的部分,然后就不需要与其他的客户端或服务器进行沟通,减少通信。