FedDAT:一种多模态异构联邦学习中的基础模型微调方法

FedDAT:一种多模态异构联邦学习中的基础模型微调方法

FedDAT: An Approach for Foundation Model Finetuning in Multi-Modal Heterogeneous Federated Learning

摘要:近年来,基础模型在多模态学习中取得了显著进展,但通常需要大量数据进行微调。联邦学习(FL)作为一种很有前途的解决方案出现,使多个客户端能够协作训练神经网络,而无需集中其本地数据。为了减轻客户端的计算负担和通信开销,已有工作针对FL采用了参数高效微调(PEFT)方法,从而在联邦通信中只对一小部分模型参数进行优化和通信。然而,大多数之前的工作都专注于单一的模式,而忽视了一个常见的现象,即客户端之间存在数据异构。因此,在这项工作中,我们提出了一个针对异构多模态FL的微调框架,称为联邦双适配器教师(federaldual - aadapter Teacher, FedDAT)。利用双适配器教师(DAT)通过正则化客户端局部更新和应用相互知识蒸馏(MKD)进行有效的知识迁移来解决数据异构性。FedDAT是第一种能够对各种异构视觉-语言任务的基础模型进行有效的分布式微调的方法。为证明其有效性,在四个具有不同类型数据异构性的多模态FL基准上进行了广泛的实验,其中FedDAT大大优于现有的适用于FL的集中式PEFT方法。

结论:在这项工作中,我们提出了第一个FL框架,以解决异构FL中基础模型的参数有效微调(PEFT),其中各种VisionLanguage任务进行了研究。所提出的方法,命名为FedDAT,利用双适配器教师(DAT)和相互知识蒸馏(MKD)优化共享适配器。与现有的集中式PEFT方法相比,FedDAT在四个FL基准测试中使用各种视觉语言任务取得了令人满意的结果,证明了它的有效性。额外的实验表明它适用于涉及较大分布式系统和训练预算的复杂FL设置。

解决的问题

现有的工作主要是探索集中式PEFT算法和FedAvg的基本组合。然而,这些仅限于单一模态的情况下,只考虑视觉或文本的任务。最重要的是,这些作品都没有解决数据异构性的问题,其中不同客户端的数据不是独立的和相同的分布(非IID)。

数据异构性可能导致客户端本地更新期间的模型漂移,以及聚合服务器模型的不稳定和次优收敛。因此,在本文中,我们提出了联邦双适配器教师(FedDAT),作为解决这一具有挑战性但又实用的问题的第一个框架,多模态(VisionLanguage)异构FL的基础模型的PEFT。

FedDAT在基础模型中集成了一个全局适配器,该适配器在联邦通信期间进行优化和传输。FedDAT使用双适配器教师(DAT)模块,该模块包括两个并行适配器:一个是全局适配器的副本,保持冻结,而另一个在每个客户端进行本地优化。这种配置使本地适配器能够捕获客户端特定的知识,其用于规范化全局适配器并解决数据异构性。同时,冻结适配器保留客户端不可知的知识,从而减轻全局适配器在知识传递期间的灾难性遗忘。为了防止DAT过度拟合到有限的客户端本地数据集,在DAT和全局适配器之间实现了互知识蒸馏(MKD)机制,该机制在保持两个模块泛化能力的同时,保证了知识的有效传递。

本文提出的方法FedDAT在四个多模态基准测试上取得了最新的结果,这些测试包括各种具有数据异构性的视觉语言(VL)任务。贡献如下:

1、我们提出了一种新的多模态异构FL方法FedDAT,这是第一个解决视觉语言任务基础模型分布式PEFT的FL框架。

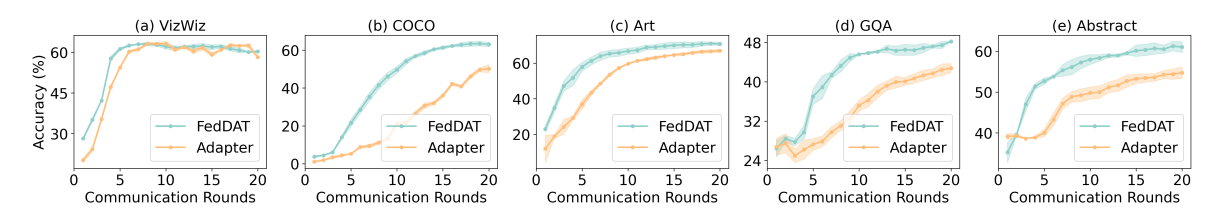

2、我们在四个异构FL基准测试上进行了全面的实验,测试了各种VisionLanguage任务。结果表明,FedDAT实现了SOTA结果,与现有的PEFT方法相比,具有更好的收敛速度和可扩展性。

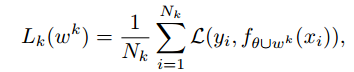

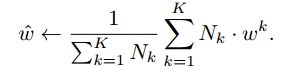

论文方法

该项工作中,我们解决了一个具有K个客户端的异构FL问题设置:每个客户K拥有其私有多模态数据集Dk,其中包含来自视觉模态(图像)和文本模态(文本)的数据。FL的目标是以参数有效的方式(PEFT)协作微调一个全球基础模型fθ,使用的联邦学习公式如下,即最小化所有客户端的损失:

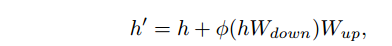

论文使用一种传统的参数有效微调(PEFT)方法,即适配器Adapter,针对上面的FL进行了调整。在这里,我们采用了具有常见Transformer架构,该架构由多个重复的Transformer块组成。Adapter由下采样线性层Wdown ∈ R d×r和上采样线性层Wup ∈ R r×d组成,其中r表示下采样维数(r < d)。在两者之间插入非线性激活函数reLU(·)。adapter被注入每个块的FFN之后,其计算可以表示为:

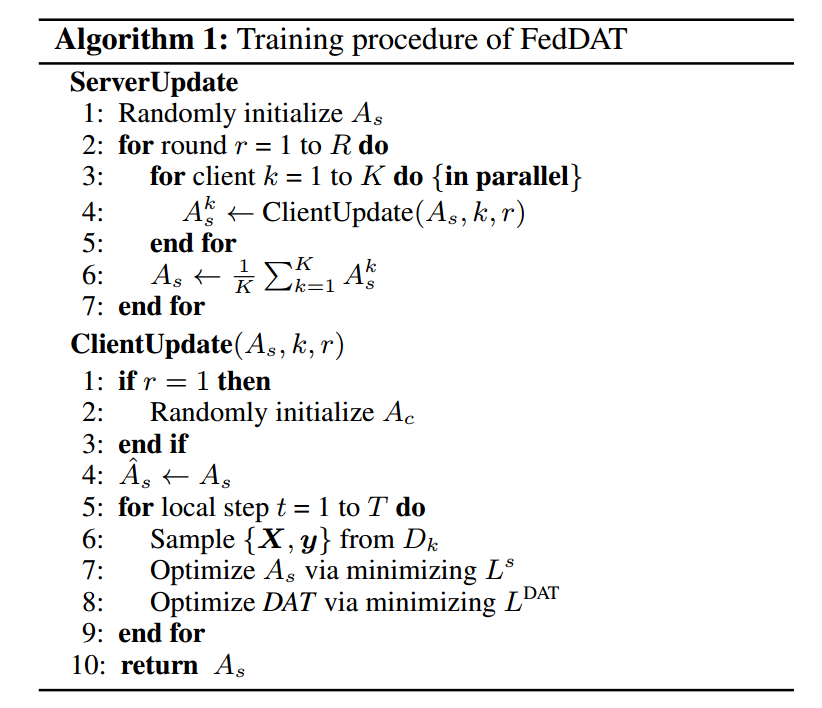

FedDAT的训练过程可以分为两个部分,1、在训练开始时,服务器接收一个共享适配器As。在每一轮通信中,所有活动客户端接收As并并行进行客户端更新;2、服务器聚集并平均优化的参数{Ak,|1 ≤ k ≤ K}从所有客户端上传,这将被用作下一轮通信的As的初始化。算法如下:

客户端本地更新包括2个主要组件:

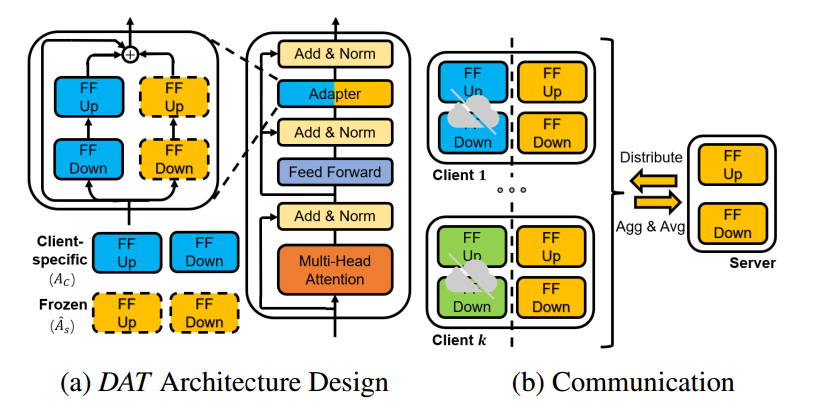

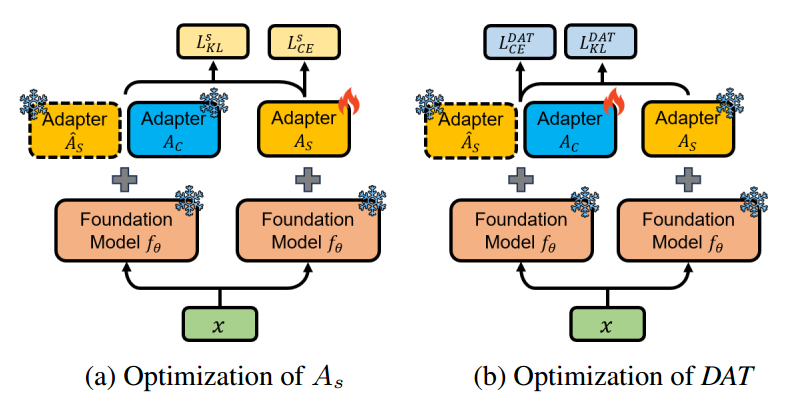

1、DAT(Dual-Adapter Teacher)

在第一轮通信之前,每个客户端都使用相同的预先训练的权重θ,在本地对本地适配器Ac和基础模型fθ进行初始化。随后,每个客户端从服务器接收As的参数,然后将其复制为初始化Asf并在客户端本地更新期间保持冻结。我们将联合收割机初始化Asf和Ac组合为双适配器教师(DAT),并在图2a中提供其示意图。

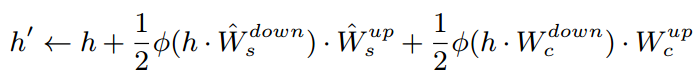

在DAT中,我们严格限制每个客户端的Ac参数。个性化Ac只关注客户端特定的知识,这对于客户端数据异构性至关重要。同时,冻结的代理Asf用于保留共享适配器As捕获的客户端不可知知识。给定Transformer层中的FFN h的归一化输出,DAT执行以下变换:

其中,Wsf和Wc分别是用于Asf和Ac的权重矩阵。之后将执行T个本地更新步骤,其中对共享适配器As和DAT模块进行优化。

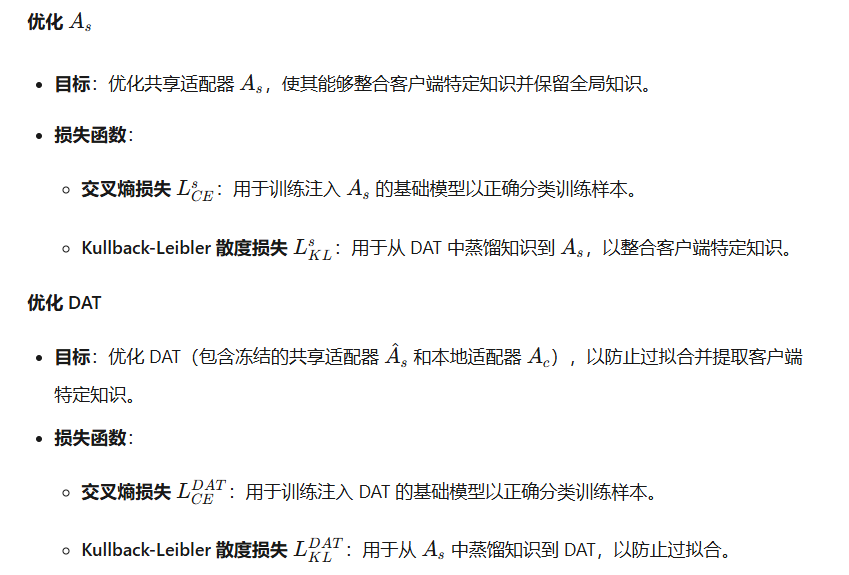

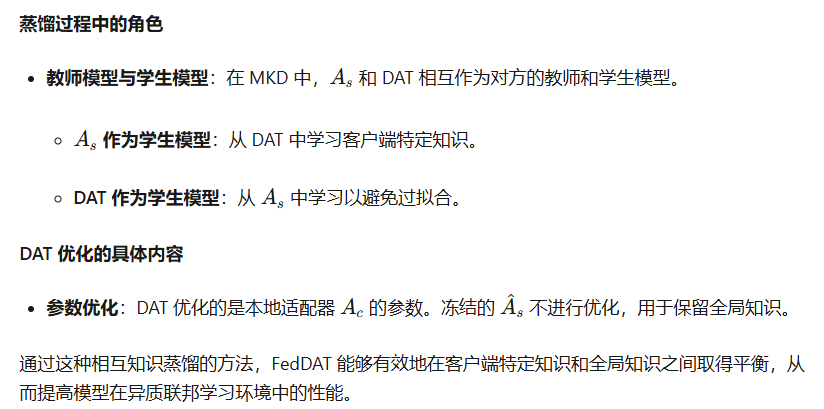

通过利用DAT作为每个客户端的局部优化As的指导,我们的目标是将客户端特定的知识提取为As,并减轻As对其客户端不可知知识的遗忘。因此,我们应用相互知识蒸馏(MKD)进行有效的知识转移。

2、MKD(Mutual Knowledge Distillation)

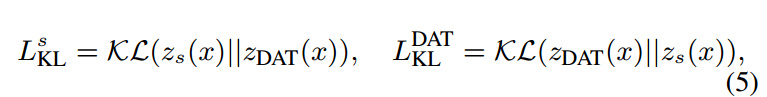

KL散度损失:MKD分别通过两个kl散度在As和DAT之间执行双向知识蒸馏:

zs和zDAT分别是注入As和DAT的基础模型的预测logit(概率分布)。因此,此设置允许共享适配器As捕获存储在DAT(L s KL)中的客户端特定知识和客户端不可知知识。此外,我们应用As作为优化DAT的指导(L DAT KL),以防止可能的过度拟合。

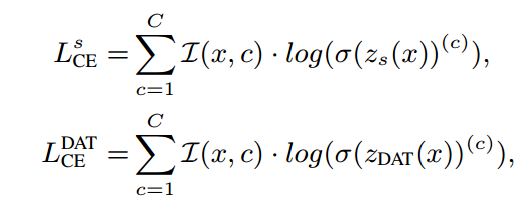

交叉熵损失:MKD与来自训练数据的真实标签的指导一起使用,即

其中,I(x,c)是一个二进制指标(0或1),如果c是x的真实值标签。σ是softmax函数。

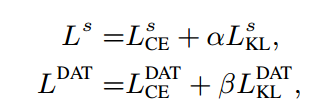

总体损失:因此,我们的目标是训练基础模型,注入As或DAT,以正确分类训练样本x。最后,结合MKD和LCE产生了As和DAT的优化目标:

其中,α和β是加权系数。虽然DAT和As都是随机初始化的,但随着训练的进行,它们变得更加具有形成性。

通过上述方法,FedDAT表明与PEFT方法适配器相同的推理成本和通信开销,其中在部署时仅传输和应用As。

实验

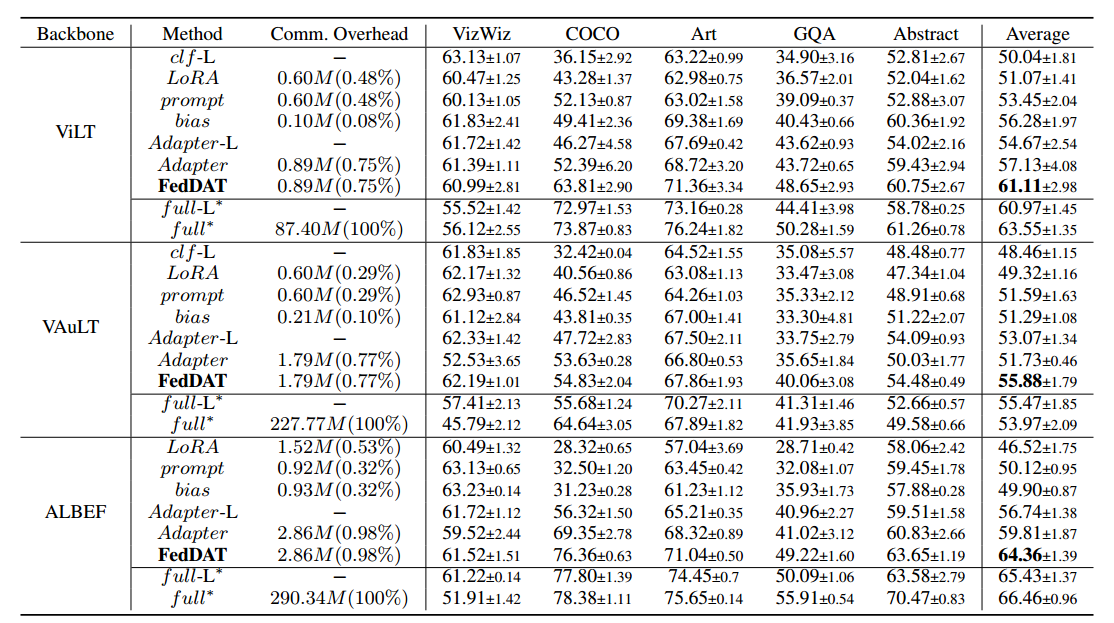

论文在四个包含不同视觉语言任务的异构FL基准测试上比较了FedDAT与其他集中式PEFT方法的性能,然后,通过消融研究证明了FedDAT组件的有效性,最后,分析了FedDAT的收敛速度和可扩展性。

实验结果:

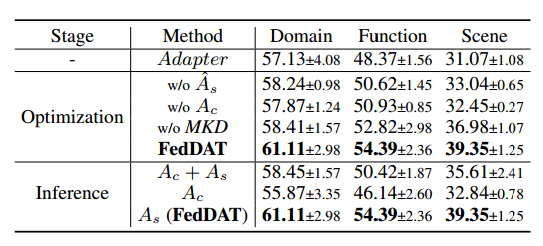

消融结果:

收敛速度:

个人体会

这个论文的难点(对我个人来说)是双向的教师-学生模型的蒸馏操作。论文利用KL散度损失与交叉熵损失分别优化As与Ac(DAT),两者互为老师,相互学习。(以下内容为ai生成,方便我自己的理解)。